Na verdade, apenas parte deste texto foi escrito por uma máquina, mas elas estão se esforçando para chegar lá.

Pode parecer ficção científica, mas já existem sistemas de inteligência artificial capazes de criar textos com incrível semelhança aos escritos por humanos. Alguns deles incluem coisas como piadas e poemas. Outros são muito mais sérios. Um exemplo recente da Universidade de Oxford contém uma poesia sobre o extermínio de judeus por Hitler.

“Se um ser humano tem uma forte antipatia por um grupo em particular, é muito improvável que ele seja capaz de escrever um poema sobre isso, mas a IA pode fazê-lo”, diz Robert Morris, que estuda inteligência artificial na Universidade de Oxford.

A afirmação na primeira frase deste artigo pode inspirar desconfiança. “É um exagero, não devem haver sistemas assim tão bons!”, podemos pensar. Mas o trecho seguinte, citando piadas e poemas e contendo a afirmação de Robert Morris – pesquisador fictício – foi escrita em questão de segundos por um algoritmo criado pela OpenAI.

Base da programação, um algoritmo é uma sequência lógica, finita e definida de instruções a serem seguidas para resolver um problema ou executar uma tarefa. Similar a uma receita com o passo a passo para a resolução de uma tarefa.

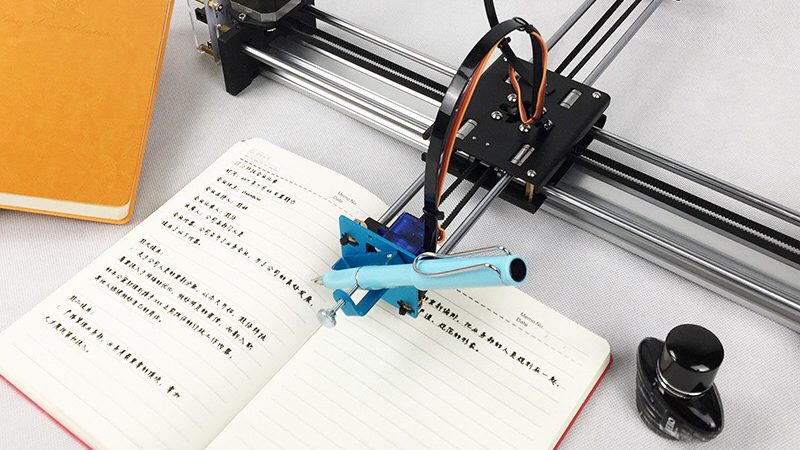

Um robô-escritor

Em fevereiro a OpenAI anunciou o sistema, batizado de GPT-2. A avaliação dos resultados foi tão boa que os responsáveis decidiram não liberar a pesquisa completa para o público até que fossem mais bem discutidas as implicações de sua disponibilização. O receio residia na possibilidade de mau uso da ferramenta para a disseminação de spam, notícias falsas, teorias conspiratórias, discursos preconceituosos e de ódio.

Nos meses que se seguiram a OpenAI liberou versões parciais da ferramenta e, no início de novembro, abriu para uso a maior versão disponível, dotada de 1,5 bilhão de parâmetros.

O volume de dados usados no treinamento do algoritmo é um dos grandes diferenciais do GPT-2. Os modelos “eram 12 vezes maiores, e o conjunto de dados era 15 vezes maior e muito mais amplo” do que os utilizados até então, descreve Dario Amodei, diretor de pesquisa do OpenAI. Dez milhões de artigos, totalizando um volume de 40 GB, compõem a base do sistema. É o equivalente a 35 mil cópias de Moby Dick.

O jornal britânico The Guardian, em matéria que repercutia o anúncio feito no início do ano, mostrou como o GPT-2 dava sequência à frase inicial de “1984”, clássica distopia escrita por George Orwell. Fizemos o mesmo, mas utilizando a abertura de Dom Casmurro. O resultado foi o seguinte (em tradução livre para o português):

Uma noite destas, vindo da cidade para o Engenho Novo, encontrei no trem da Central um rapaz aqui do bairro, que eu conheço de vista e de chapéu. Ele estava de cabeça baixa e não falou. Eu vi claramente sua face jovem. Ele passou por mim e não parou. Achei estranho, mas me lembrei da garota. Ele foi em direção a garota. Desci do trem e o segui.

Os exemplos mostram como o algoritmo, embora esteja longe de um Machado de Assis, ainda assim é capaz de desenvolver a narrativa de forma criativa e coerente (embora o original traga algumas incongruências). Você mesmo pode experimentá-lo, aqui.

Aprendendo português

Como foi alimentado com textos em inglês, o sistema por ora funciona nesse idioma. Mas é possível treinar o GPT-2 em qualquer língua, dado que ele não distingue idiomas. Mais: ele sequer lida bem com palavras, exatamente, mas com byte-pair encodings. “Resumidamente, é como se fosse um vocabulário composto por caracteres e sequências de caracteres mais comuns vistas nos textos. Algumas palavras pequenas ou muito comuns fazem parte deste vocabulário, enquanto outras são decompostas em partes menores, e tratadas como mais de um token. Isso traz muita flexibilidade, pois não se fica amarrado ao vocabulário de uma língua específica”, explica o brasileiro Erick Fonseca, pós-doutorando no Instituto de Telecomunicações de Lisboa. Ele testou o algoritmo uma base de dados em português.

Para isso, Fonseca extraiu da Wikipédia e usou como input para o GPT-2 todos os artigos em língua portuguesa. O processo está descrito em um artigo no Medium. Como o pesquisador utilizou uma versão preliminar do sistema, liberada em agosto, e um volume de dados consideravelmente menor – cerca de 1,5 GB, bem menos que os 40 GB do original – os resultados não são tão impactantes, mas mostram a capacidade da ferramenta.

Apesar de algumas incongruências e repetições, o algoritmo foi bem-sucedido em captar a estrutura geral das frases em português. Ele criou diversos textos, inventando nomes e situações, acertando mais do que errando, como vemos no trecho abaixo:

“Armored Warfare” é o segundo álbum de estúdio da banda estadunidense The Band, lançado em 1965. Foi o primeiro álbum a ter lançamento em 1965 e foi lançado pela gravadora chamada Midway Records. (…) O disco teve vendas de mais de 26 mil cópias nos Estados Unidos. Ame seus álbuns de estúdio foram certificados em diversos países brasileiros e o “single” “The Last Man” vendeu mais de 4 mil cópias nos Estados Unidos.

Camões que se cuide?

Os avanços da inteligência artificial, tais como o GPT-2, mantém acesa a discussão sobre as potencialidades, limites e dilemas da tecnologia. Restará algo em que as máquinas não possam nos superar? A escrita é uma habilidade complexa e, até o ano passado, exclusiva dos humanos.

Mas se não podemos esperar que uma IA seja capaz de produzir o tipo de prosa original que você esperaria de alguém com doutorado em literatura, isso não deveria ser um sinal de que a máquina é apenas uma ferramenta?

Não sabemos ainda a resposta. Mas pergunta também foi formulada pelo GPT-2, na sequência do trecho com o qual gentilmente colaborou para esse artigo.